این مدل قادر به پردازش متون و تصاویر است.

تنها دو ماه پس از عرضه جدیدترین مدل هوش مصنوعی بزرگ متا، این شرکت با یک آپدیت بزرگ دیگر برگشته است. Llama 3.2 نخستین مدل متنباز متا است که میتواند علاوهبر متون، تصاویر، جداول، نمودارها و کپشن عکسها را هم پردازش کند.

مدل هوش مصنوعی متا Llama 3.2 به توسعهدهندگان اجازه میدهد اپلیکیشنهای هوش مصنوعی پیشرفته ازجمله اپهای واقعیت مجازی که میتوانند در لحظه ویدیوها را درک کنند، موتورهای جستجوی بصری که قادر به مرتبسازی تصاویر براساس محتوا هستند، یا ابزارهایی برای تحلیل اسناد بسازند که میتوانند متون طولانی را برای شما خلاصه کنند.

متا میگوید راهاندازی مدل هوش مصنوعی لاما 3.2 راحت است. توسعهدهندگان تنها کافی است حالت جدید چندوجهی را به مدل خود اضافه کنند تا بتوانند تصویر بهنمایش بگذارند و امکان تعامل با این فایلها را فراهم کنند.

با توجه به اینکه OpenAI و گوگل پیشتر مدلهای چندوجهی خود را معرفی کرده بودند، متا با Llama 3.2 سعی دارد عقبماندگی خود را جبران کند. افزودن قابلیت بینایی - یعنی امکان پردازش تصویر - نقش مهمی برای آینده برنامههای این شرکت دارد، چراکه آنها مشغول توسعه توانمندیهای هوش مصنوعی برای سختافزارهایی مثل عینکهای متا ریبن هستند.

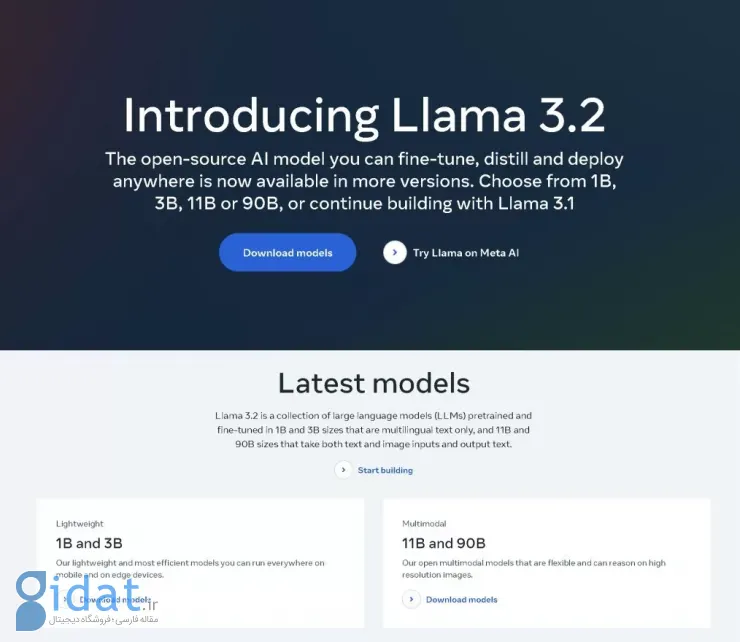

لاما 3.2 دارای دو مدل بینایی (با 11 و 90 میلیارد پارامتر) و دو مدل سبک متنی (با 1 و 3 میلیارد پارامتر) است. مدلهای کوچکتر طراحی شدهاند تا با سختافزارهای کوالکام، مدیاتک و دیگر سختافزارهای مبتنی بر آرم کار کنند. این شرکت احتمالاً امید دارد که این مدلها به گوشیهای همراه نیز وارد شوند.

متا میگوید Llama 3.2 در زمینه تشخیص تصویر و فهم دیگر عناصر بصری رقیب Claude 3 Haiku از شرکت انتروپیک و GPT4o-mini از شرکت OpenAI است. اما در زمینههایی همچون دنبالکردن دستورات، خلاصهسازی محتوا و بازنویسی پرامپت بهتر از Gemma و Phi 3.5-mini عمل میکند.

مدلهای Llama 3.2 همین حالا از طریق وبسایت Llama.com و Hugging Face و دیگر پلتفرمهای همکار متا در دسترس قرار گرفتهاند.

پاسخ ها