این شورا از چهار مدیرعامل شرکتهایی مانند Stripe تشکیل شده و در یک گزارش از حضور «چهار مرد سفید پوست» در آن انتقاد شده است.

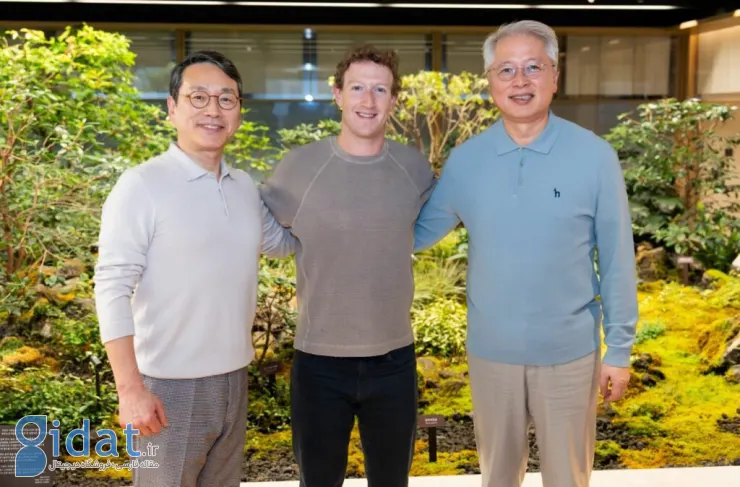

«مارک زاکربرگ»، مدیرعامل متا، شورای مشاوره محصول جدیدی ایجاد کرده است. اعضای این شورا بهصورت دورهای با تیم مدیریت متا جلسه خواهند داشت تا در مورد پیشرفتهای هوش مصنوعی و سایر فناوریهای غول فناوری، مانند متاورس به آنها مشاوره بدهند.

براساس گزارش بلومبرگ، این شورا که نام آن گروه مشاوره متا (The Meta Advisory Group) انتخاب شده است، از چهار مدیرعامل تشکیل خواهد شد: «پاتریک کولیسون»، مدیرعامل و همبنیانگذار Stripe، «نَت فریدمن»، مدیرعامل سابق GitHub، «توبی لوتکه»، مدیرعامل Shopify و «چارلی سونگورست»، سرمایهگذار و مدیرسابق مایکروسافت.

زاکربرگ در یک یادداشت داخلی برای کارمندان متا نوشت:

«عمیقاً به این گروه از افراد و دستاوردهای آنها در حوزههای مربوطه احترام میگذارم و سپاسگزارم که آنها مایل هستند دیدگاههای خود را در چنین زمان مهمی که فرصتهای جدیدی را با هوش مصنوعی و متاورس به دست میآوریم، با متا در میان بگذارند.»

متا در حال حاضر یک هیئت مدیره 11 نفره دارد، هرچند «شریل سندبرگ»، برای انتخاب مجدد در نشست سالانه متا در پایان ماه نامزد نخواهد شد. به گفته سخنگوی شرکت، گروه مشاوره متا با هیئت مدیره آن تفاوت دارد، زیرا اعضای آن توسط سهامداران انتخاب نمیشوند و آنها در قبال شرکت وظیفه امانتداری ندارند.

این گروه در حالی تشکیل شده که متا بهدنبال تمرکز روی محصولات مبتنی بر هوش مصنوعی است. غول فناوری تاکنون دستگاههای سختافزاری مختلفی مانند هدستهای واقعیت مجازی Quest و عینکهای هوشمند Ray-Ban را عرضه کرده است. همچنین محصولات نرمافزاری مانند دستیار هوش مصنوعی متا را از طریق چندین برنامه در دسترس مصرفکنندگان خود قرار داده است.

در نهایت، میتوان به گزارش انتقادی تک کرانچ از تشکیل گروه مشاوره متا نیز اشاره کرد که در آن گفته شده مارک زاکربرگ در این گروه از چهار مرد سفید پوست کمک گرفته است! در واقع این گزارش میگوید که گروه مشاورهای جدید متا (صرفنظر از اندازه نسبتاً کوچکتر آن) از نظر جنسیت و نمایندگی نژادی، با هیئت مدیره و هیئت نظارت آن متفاوت است. در ادامه آن ادعاشده که زنها و افراد رنگینپوست بیشتر با جنبههای تاریک و خطرناک هوش مصنوعی مواجه میشوند.

«سارا مایرز وست»، مدیر عامل موسسه غیر انتفاعی AI Now که پیامدهای اجتماعی هوش مصنوعی را مطالعه میکند، به TechCrunch میگوید:

«این فناوری مستعد خطا است، و ما با انجام تحقیقات مستقل میدانیم که این خطاها بهطور مساوی توزیع نمیشوند، آنها به طور نامتناسبی به جوامعی آسیب میرسانند که بارها بار تبعیض را تحمل کردهاند.»

پاسخ ها