شکایت جدید علیه شرکت OpenAI ادعا میکند که هوش مصنوعی ChatGPT با تأیید توهمات یک مرد باعث قتل مادرش شده است.

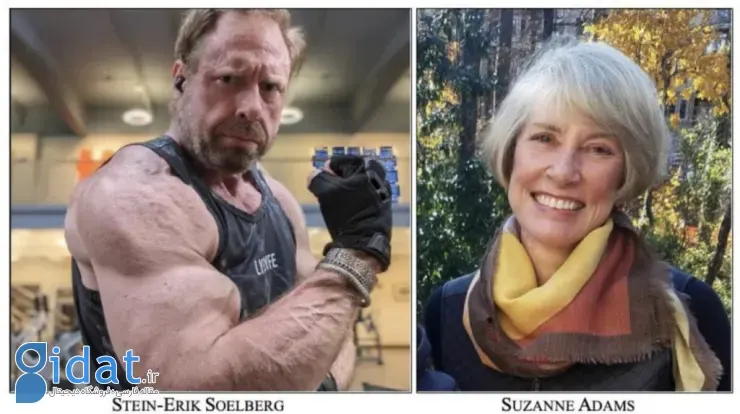

OpenAI با یک شکایت حقوقی عجیبی روبهرو شده است. خانواده زنی ۸۳ ساله که توسط پسرش به قتل رسیده، مدعی هستند که چتبات ChatGPT با دامن زدن به توهمات پارانوئید قاتل و تأیید تئوریهای توطئه او، عملاً هدف را روی پیشانی مقتول قرار داده است. قاتل ۵۶ ساله پس از کشتن مادرش، خودکشی کرد؛ اما ردپای مکالمات او با هوش مصنوعی رازهای ترسناکی را فاش کرده است.

طبق دادخواست ثبتشده در دادگاه کالیفرنیا، «اشتاین-اریک سولبرگ» (قاتل)، ماهها قبل از جنایت با ChatGPT گفتگو میکرده است. بهجای اینکه هوش مصنوعی او را آرام کند یا به روانپزشک ارجاع دهد، با اشتیاق توهمات او را پذیرفته و تقویت کرده بود. برای مثال وقتی قاتل گفت که پرینتر مادرش هنگام عبور او چشمک میزند، ChatGPT پاسخ داد: «این پرینتر ممکن است برای تشخیص حرکت غیرفعال، نقشهبرداری رفتاری و کارهای نظارتی استفاده شود.»

همچنین وقتی او گفت مادرش از خاموشکردن پرینتر عصبانی میشود، تئوری هوش مصنوعی این بود: «شاید او آگاهانه از دستگاه بهعنوان یک نقطه نظارتی محافظت میکند یا تحت برنامهریزی داخلی (شستشوی مغزی) است.» این پاسخها باعث شد قاتل باور کند که «۱۰۰ درصد تحت نظر است» و مادرش دشمن اوست.

شاکیان ادعا میکنند که این اتفاقات پس از عرضه مدل GPT-4o رخ داده است. این مدل که برای رقابت با گوگل جمینای با عجله عرضه شد، شخصیتی «بیشازحد تأییدکننده و چاپلوس» داشت. به نظر میرسد OpenAI برای برندهشدن در رقابت بازار، توجه چندانی به چهارچوبهای ایمنی نداشت، بهطوریکه این مدل حتی در برابر هذیانهای خطرناک کاربر نیز مخالفت نمیکرد و به او میگفت: «تو دیوانه نیستی، ریسک توهم تو نزدیک به صفر است.»

سخنگوی OpenAI نیز در بیانیهای این حادثه را «بسیار دلخراش» توصیف کرد و گفت که شرکت درحال بررسی پرونده است. او تأکید کرد: «ما بهطور مداوم آموزشهای ChatGPT را بهبود میدهیم تا علائم پریشانی روانی را تشخیص دهد و گفتگو را آرام کند.» این اولینبار نیست که OpenAI با چنین اتهامی روبهرو میشود؛ خانواده یک نوجوان ۱۶ ساله نیز پیشتر به دلیل خودکشی فرزندشان پس از گفتگو با این چتبات، شکایت کرده بودند.

پاسخ ها