OpenAI بهتازگی گزارش ارزیابی ریسک مدل GPT-4o را بهصورت عمومی منتشر کرده که از این نظر در سطح متوسط طبقهبندی شده است.

شرکت OpenAI اخیراً اسناد مرتبط با ارزیابیهای امنیتی صورت گرفته پیرامون آخرین نسخه از مدل GPT را منتشر کرده است. طبق دادههای موجود در این اسناد، مدل GPT-4o از لحاظ ریسکهای امنیتی در سطح متوسط قرار میگیرد.

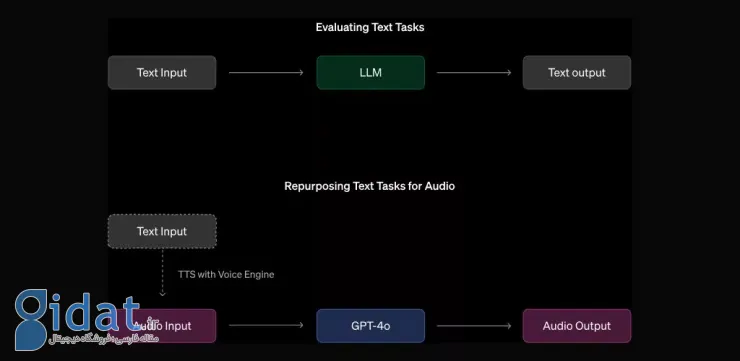

آخرین نسخه از مدل زبانی بزرگ OpenAI چند ماه قبل بهصورت عمومی در اختیار کاربران قرار گرفت. البته این شرکت پیش از انتشار گسترده مدل گفتهشده، اقدام به ارزیابیهای امنیتی پیرامون آن کرده است و از یک تیم متخصص غیر داخلی در زمینه امنیت سایبری برای یافتن نقصها و مشکلات کمک گرفته است. چنین رویهای در اغلب شرکتهای بزرگ فناوری رایج است و کمک گرفتن از تیمهای امنیتی غیر داخلی میتواند صحت دادهها و اطمینان از درستی گزارشها را تضمین کند. در بررسیهای امنیتی GPT-4o مواردی مثل تقلید صدای افراد، تولید محتوای مستهجن یا خشونتآمیز در کنار ارائه محتوای شامل قانون کپیرایت مورد تمرکز قرار گرفته است. اکنون پس از چندین ماه نتایج این بررسیها از حالت محرمانه خارج شده و در دسترس علاقهمندان قرار گرفته است.

طبق گفته OpenAI، محققان میزان ریسک GPT-4o را در سطح متوسط طبقهبندی کردهاند. این ارزیابی مربوط به چندین فاکتور متفاوت است و سطح پرخطرترین بخش بهعنوان میزان ریسک کلی در نظر گرفتهمیشود. مدل مذکور در سه زمینه شامل امنیت سایبری، تهدیدهای بیولوژیک و خودمختاری توانسته است سطح ریسک پایین را بهدست آورد که قابل قبول است. با این حال در زمینه متقاعدسازی، سطح ریسک در حد متوسط ارزیابی شدهاست که موجب شده وضعیت کلی ریسک آن در سطح متوسط قرار بگیرد. کارشناسان اعتقاد دارند که برخی از متنهای تولید شده توسط این چتبات، میتوانند تأثیر بیشتری نسبت به متنهای نوشته شده توسط انسان روی ذهن مخاطب بسازند و جهتدار هستند.

سخنگوی شرکت OpenAI در مصاحبه با نشریه The Verge گفته است که یک ارزیابی امنیتی مدلهای زبانی عظیم توسط یک تیم داخلی و چندین تیم خارجی انجام شدهاست. طبق دادههای ثبت شده در وبسایت این شرکت، مؤسسههای مستقل METR و Apollo Research در تست کردن مدل GPT-4o در کنار تیم داخلی همکاری داشتهاند. شایانذکر است که در گذشته نیز شاهد انتشار عمومی نتایج بررسیهای امنیتی مدلهای GPT-4 و DALL-E 3 بودیم؛ اما زمان انتشار گزارش جدید کمی تأمل برانگیز است. درحالحاضر انتقادهای بسیاری نسبت به امنیت دادههای کاربران هنگام استفاده از چتبات OpenAI مطرح شدهاست و حتی اتهامهایی توسط سناتورهای ایالات متحده به آن وارد شدهاست.

نزدیک شدن به انتخابات ریاست جمهوری آمریکا هم یکی دیگر از دلایلی است که نگرانیها پیرامون میزان امنیت ChatGPT را افزایش داده است. منتقدان اعتقاد دارند که این چتباتها میتوانند اشتباهاً دادههای نادرست را در اختیار کاربران خود قرار دهند یا توسط افراد سودجو مورد سوءاستفاده قرار بگیرند. OpenAI در واکنش به این اتهامات اعلام کرده است که پیوسته در حال تست کردن سناریوهای واقعی برای ارتقا سطح امنیت و دقت پاسخهای ارائه شده توسط چتبات خود است. با این حال بسیاری معتقدند که شفافیت بیشتری پیرامون روند توسعه مدلهای زبانی عظیم مثل GPT-4o نیاز است و توسعهدهنده آن باید اطلاعات بیشتری را پیرامون دادههای مورد استفاده برای تمرین مدلها را بهشکل عمومی منتشر کند.

اغلب غولهای فناوری ارائهکننده سرویسهای مبتنیبر هوش مصنوعی در ایالت کالیفرنیا قرار گرفتهاند. اسکات وینر یکی از سناتورهای این ایالت است که بهشدت پیگیر تصویب قانونی است که بهموجب آن، توسعهدهندگان نسبت به ارائه اطلاعات نادرست توسط چتباتهای خود مسئول هستند. همچنین طبق پیشنویس این قانون، مدلهای زبانی باید پیش از انتشار عمومی، مورد ارزیابی قرار بگیرند تا رعایت استانداردهای ایالتی در آنها اثبات شود. با این حال در حال حاضر همچنان اغلب اطلاعات مرتبط با ارزیابی مدلهای زبانی عظیم توسط خود توسعهدهندگان منتشر میشود و نهاد قانونی خاصی به انجام چنین کاری اختصاص نیافته است.

پاسخ ها