آیا میتوان هوش مصنوعی را مسئول دانست؟ یک پژوهشگر اخلاق هوش مصنوعی به این سؤال پاسخ میدهد.

یک پژوهشگر اخلاق هوش مصنوعی باور دارد مردم و کاربران نقش مهمی در توسعه مسئولانه هوش مصنوعی دارند؛ چرا که این فناوری از کنش کاربران بازخورد میگیرد. به باور وی، بایستی عموم جامعه به آگاهی و دانش مناسبی نسبت به این تکنولوژی دست یابند و نباید تنها طراحان آن را مسئول رفتار اخلاقی هوش مصنوعی بدانیم.

هسته حکمرانی و هوش مصنوعی مرکز رشد و خانه خلاق و نوآوری پژوهشگاه فرهنگ و اندیشه، اولین جلسه از کارگاه دانشافزایی هوش مصنوعی را برگزار کرد. در این جلسه مروری بر «معضل شکاف مسئولیت در هوش مصنوعی» انجام و راهکارهایی برای توسعه مسئولانه آن ارائه شد.

«سعیده بابایی»، پژوهشگر اخلاق هوش مصنوعی دانشگاه توبینگن آلمان، در این کارگاه به چهار راهبرد برای توسعه مسئولانه فناوریهای هوش مصنوعی اشاره کرد و گفت:

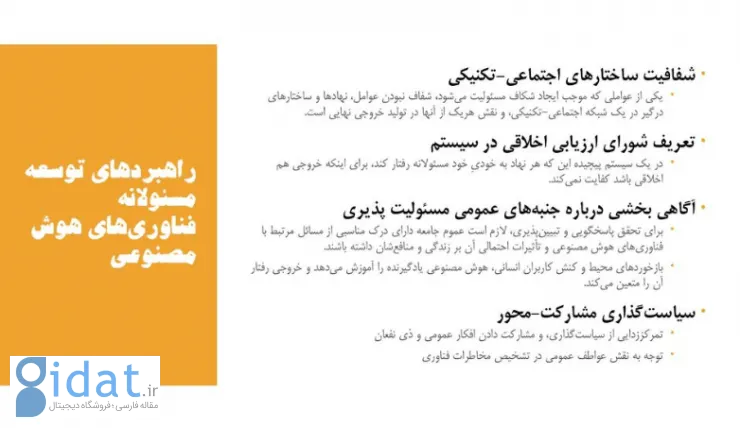

«یکی از عواملی که موجب میشود با شکاف مسئولیت روبهرو شویم، شفافنبودن عاملها و ساختارهایی است که در توسعه یک تکنولوژی و کاربردیشدن آن مسئول هستند. نقش هر یک از آنها در خروجی نهایی که تولید میشود، بهاندازه کافی شفاف نیست. این راهبرد ما را متوجه میکند که باید شبکه عاملها را دقیقتر شناسایی کنیم.»

او تعریف شورای ارزیابی اخلاقی در سیستم را یکی دیگر از راهبردهای توسعه مسئولانه هوش مصنوعی عنوان کرد و گفت: «در یک سیستم پیچیده، رفتار مسئولانه هر نهاد بهخودیخود برای اینکه خروجی هم اخلاقی باشد، کفایت نمیکند؛ زیرا اگر نگاه کلان اخلاقی به سیستم وجود نداشته باشد، ممکن است موضوعات اخلاقی در یک سیستم پیچیده از نظر غافل بماند.»

او با تأکید بر اینکه نقش کاربر بر توسعه هوش مصنوعی را باید بسیار جدیتر مورد بررسی قرار داد، اظهار داشت که بازخوردهای محیط و کنش کاربران انسانی، هوش مصنوعی یادگیرنده را آموزش میدهد و خروجی رفتار آن را معین میکند:

«کاربران عناصر منفعل نیستند و میتوانند عاملیتی جدی داشته باشند. از چند جهت نقش آنها مهم است؛ پاسخگوبودن نسبت به کاربران تا حد زیادی اهمیت دارد و توجه به ضرورت پاسخگوبودن منجر به تلاش بیشتر برای شفافترشدن مسیر توسعه هوش مصنوعی میشود.»

این پژوهشگر باور دارد برای اینکه پاسخگویی در عمل محقق شود، باید عموم جامعه یک آگاهی و دانش مناسب و کافی نسبت به هوش مصنوعی پیدا کنند: «مثلاً کدام تکنولوژیهایی که روزمره از آنها استفاده میکنند، در آنها هوش مصنوعی بهکار رفته است و چه اثراتی روی زندگی آنها دارد. بنابراین آگاهکردن مردم و کاربر مهم است.»

وی با بیان اینکه سیستمهای هوش مصنوعی از محیط یاد میگیرند، اظهار داشت این سیستمها از کنش کاربران بازخورد میگیرند و داده جدید وارد اینها میشود که خروجی رفتارشان را تعیین میکند: «کاربران یک بخش از فرایند توسعه را با تعامل با این سیستمها رقم میزنند. بنابراین میتوان ادعا کرد که توسعه یک فناوری مثل هوش مصنوعی درواقع یک عمل جمعی است. این درحالی است که غالب مردم از نقش فعال و مهمی که میتوانند داشته باشند، بیخبر هستند؛ اما ما صرفاً جامعه طراحان را مسئول میدانیم.»

به گفته بابایی، در راستای توسعه مسئولانه هوش مصنوعی، پیشنهاد شده است تا از سیاستگذاری، تمرکززدایی شود و افکار عمومی و ذینفعان در پروسه توسعه هوش مصنوعی مشارکت داده شوند:

«کاربران حق دارند در تکنولوژیهایی که زندگیشان را شکل و تغییر میدهد، نقش داشته باشند. همچنین بسیاری اوقات خرد جمعی که در افکار عمومی وجود دارد، میتواند یک آگاهی جدید و متفاوتی را درباره جنبههای اخلاقی تکنولوژیهای مختلف ازجمله هوش مصنوعی، با خود بههمراه آورد.»

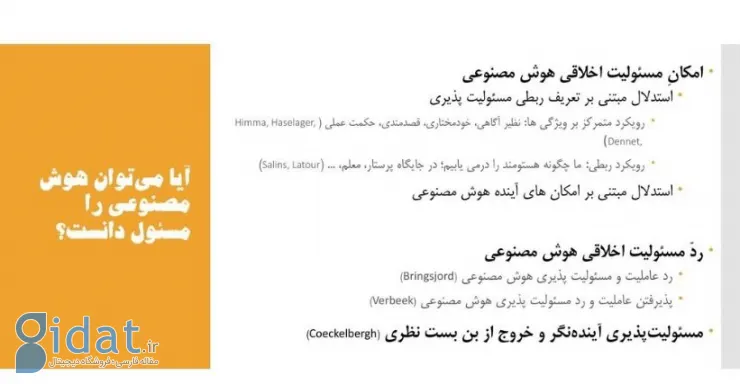

این پژوهشگر هوش مصنوعی در بخش دیگری از سخنان خود به امکان مسئولیت اخلاقی هوش مصنوعی اشاره کرد و گفت در این رابطه دو استدلال مبتنی بر «تعریف ربطی مسئولیتپذیری» و «امکانهای آینده هوش مصنوعی» وجود دارد.

او معتقد است در رویکرد ربطی، شباهت زیادی بین عمل هوش مصنوعی و عمل انسانی وجود دارد: «اگر در بسیاری از موقعیتهایی که هوش مصنوعی میتواند بهطور بالقوه در آنها قرار گیرد، تکنولوژی را با عامل انسانی جایگزین کنیم، میتوانیم آن موقعیت را یک موقعیت اخلاقی تلقی کنیم؛ مثلاً هوش مصنوعی جای یک معلم یا پرستار سالمند قرار گیرد.»

بابایی با اشاره به اینکه جان سالینز از مدافعین این رویکرد است، اظهار داشت به باور این فرد مفهوم خودمختاری که در ذهن عامه مردم درباره هوش مصنوعی شکل گرفته است، بایستی تغییر کند:

«هوش مصنوعی را میتوان با سگهای دستآموزی که به افراد نابینا کمک میکنند، مقایسه کرد. همانطور که این یک عمل اخلاقی است که مورد تحسین ما قرار میگیرد، هوش مصنوعی را نیز اگر در این موقعیت قرار دهیم، میتواند شایسته تحسین ما باشد. این هم متوجه مربی سگ و هم خود سگ است که شایسته تحسین است.»

او با طرح این سؤال که آیا میتوان هوش مصنوعی را مسئول دانست یا خیر، گفت گروهی از اندیشمندان بر این باورند که نمیتوان امکان مسئولیت اخلاقی برای هوش مصنوعی قائل بود. درواقع طی این استدلال، عاملیت اخلاقی هوش مصنوعی رد میشود و به این دلیل که نمیتواند عاملیت داشته باشد، پس مسئولیتپذیر هم نیست:

«بار مسئولیت و عملی که تولید میشود و ممکن است یک خروجی نامطلوب ایجاد کند، باید منحصراً بر دوش انسانها گذاشته شود. راهبردی که این دسته از اندیشمندان پیگیری میکنند، این است که هوش مصنوعی نمیتواند شرایط پذیرفتن مسئولیت را احراز کند»

اما در استدلال گروه دوم، هوش مصنوعی حائز عاملیت شرایط اخلاقی است، اما مسئول آن نیست. بابایی دراینباره گفت: «هوش مصنوعی فاقد مسئولیت اخلاقی است. در تعامل بین انسان و تکنولوژی، تکنولوژی به نحو فعالانهای بین انسان و جهان انسانها وساطت میکند. تکنولوژی یک نوع عاملیتی از خود نشان میدهد، اما از آنجا که انسانها طراح این تکنولوژی هستند، مسئولیت اتفاقات ناخواسته رخ داده هم بر عهده انسانهاست. فلوریدی و سانترز معتقدند اگر خروجی هوش مصنوعی بهاندازه کافی شبیه به انسان باشد، کفایت میکند که عاملیت را به هوش مصنوعی نسبت دهیم؛ اما نه به آن معنا که مسئولیت را به انسان واگذار میکنیم. البته هوش مصنوعی را میتوان پاسخگو دانست تا اگر یک عاملی منجر به فعلی غیراخلاقی شود، آن فعل را اصلاح یا عامل را حذف کند.»

پاسخ ها