بدون برنامهنویسی و کدهای رایانهای انجام بسیاری از کارهای علمی امکان پذیر نمیشد و جهان هیچگاه به پیشرفتهای امروزی نمیرسید. اما ۱۰ کدی که جهان را تغییر دادند چه بودند؟

به گزارش ایسنا و به نقل از نیچر، در سال ۲۰۱۹ گروه تحقیقاتی "تلسکوپ افق رویداد"(Event Horizon Telescope) اولین تصویر از سیاهچاله را به جهانیان نشان دادند. اما تصویر درخشان یک شی حلقه مانند که گروه از آن رونمایی کردند یک تصویر عادی نبود بلکه یک تصویر رایانهای بود.

با انجام محاسبات ریاضیاتی بر روی دادههای به دست آمده از تلسکوپهای رادیویی در ایالات متحده، مکزیک، شیلی، اسپانیا و قطب جنوب این دادهها تغییر کرده و تبدیل به تصویر شد. این گروه کد کامپیوتری که برای انجام این کار استفاده کرده بودند را در کنار مقالاتشان منتشر کردند تا جامعهی علمی کاری که آنها انجام داده بودند را ببیند و از آن برای رسیدن به موفقیتهای بعدی استفاده کنند. این یک الگوی رو به افزایش است. از ستارهشناسی گرفته تا جانورشناسی پشت هر کشف بزرگ علمی در عصر جدید یک کامپیوتر وجود دارد.

مایکل لویت(Michael Levitt) یک زیستشناس محاسباتی در دانشگاه "استنفورد" کالیفرنیا یکی از برندگان جایزهی نوبل شیمی در سال ۲۰۱۳ بوده است. او این جایزه را برای کار بر روی استراتژیهای مدلسازی در ساختارهای شیمیایی دریافت کرد. لویت خاطرنشان کرد که لپتاپهای امروزی ۱۰ هزار برابر حافظه و سرعت بیشتری نسبت به کامپیوتر آزمایشگاه او در سال ۱۹۶۷ دارند. زمانی که کار بر روی پروژهاش که برندهی نوبل شد را آغاز کرد.

او میگوید: ما امروزه تجهیزات محاسباتی فوقالعادهای در دست داریم اما مشکل اینجاست که هنوز نیاز به فکر کردن داریم. یک کامپیوتر قوی بدون وجود نرمافزاری که بتواند سوالات دانشمندان را پاسخ دهد و محققانی که بدانند چگونه کدنویسی کنند و از آن استفاده کنند بیمصرف است.

نیل چو هونگ(Neil Chue Hong) مدیر موسسهی "Software Sustainability" که دفتر مرکزی آن در ادینبرو اسکاتلند است و مرکزی برای بهبود توسعه و استفاده از نرم افزار در علوم است میگوید: تحقیقات امروزه کاملا به نرمافزارها وابسته هستند. و پارامترهای آن تمام جنبههای تحقیقات را شامل میشود.

کشفهای جدید در رسانهها منتشر میشوند اما در اینجا میخواهیم پشت صحنهی این کشفها و بخش اصلی آن یعنی کدهایی که تحقیقات را در طی چند دههی گذشته متحول کردهاند بررسی کنیم.

اگرچه هیچ لیست این چنینی نمیتواند قطعی باشد اما ما طی سال گذشته از دهها محقق نظرسنجی کردیم تا مجموعهای از ۱۰ نرمافزار که تاثیری بزرگ بر علم داشتند را مشخص کنیم.

همگردان فورترن: پیشگام در زبان برنامهنویسی(۱۹۵۷)

استفاده از اولین کامپیوترها کار راحتی نبود و برنامهنویسی به معنای واقعی کلمه با دست و با اتصال مجموعهی مدارها و سیمها انجام میشد. دستگاههایی که بعد از آن آمد و زبان برنامهنویسی همگذاری(نوعی برنامهنویسی سطح پایین) به کاربران کمک کرد تا کامپیوترها را با کد برنامهنویسی کنند. اما همچنان نیاز به دانش ساختاری کامپیوتر بود. بنابراین هنوز این کار از دسترس بیشتر دانشمندان خارج بود.

این موضوع در دههی ۱۹۵۰ با توسعهی زبان برنامهنویسی نمادین به خصوص با توسعهی زبان برنامهنویسی فورترن(Fortran) که توسط جان باکس(John Backus) و گروهش در موسسهی آیبیام در سنخوزه کالیفرنیا ایجاد شده بود تغییر کرد. با استفاده از زبان برنامهنویسی فورترن کاربران میتوانند برنامهنویسی را با دستورالعملهایی که برای انسانها قابل خواندن است انجام دهند. یک همگردان(compiler) سپس این دستورالعملها را به یک کد سریع و کارآمد ماشینی تبدیل میکند.

اگرچه هنوز هم برنامهنویسی کار آسانی نبود. در ابتدای کار برنامهنویسان از مجموعهای کارت برای وارد کردن کدها استفاده میکردند و برای یک شبیهسازی پیچیده دهها هزار کارت نیاز بود. سیوکورو مانابه(Syukuro Manabe) اقلیم شناس در دانشگاه پرینستون نیوجرسی میگوید: فورترن برنامهنویسی را برای آن دسته از محققانی که دانشمند در زمینه کامپیوتر نبودند نیز ممکن کرد. برای اولین بار توانستیم خودمان برنامهنویسی را انجام دهیم. او و همکارانش از این زبان برنامهنویسی استفاده کردند تا یکی از موفقترین مدلهای اقلیمی را بسازند.

اکنون پس از گذشت هشت دهه فورترن همچنان به طور گستردهای استفاده میشود. از جمله در مدلسازی اقلیمی، دینامیک سیالات، شیمی محاسباتی و هر موضوعی که در آن از جبر خطی پیچیده استفاده شود و نیاز به کامپیوترهای قدرتمند برای بررسی سریع اعداد باشد. کدی که در نتیجه به دست میآید سریع است و هنوز تعداد زیادی از برنامهنویسان وجود دارند که میدانند چگونه آن را بنویسند. نوع قدیمی برنامهنویسی فورترن هنوز هم در آزمایشگاهها و ابررایانهها در سراسر جهان مورد استفاده قرار میگیرد.

پردازنده سیگنال: "تبدیل فوریه" سریع(۱۹۶۵)

هنگامی که اخترشناسان رادیویی آسمان را بررسی میکردند سیگنالی پیچیده یافتند که با گذر زمان تغییر میکرد. برای فهمیدن ماهیت این امواج رادیویی آنها باید میفهمیدند که این سیگنالها به عنوان تابع فرکانسی چه شکلی دارند. انجام یک فرآیند ریاضیاتی به نام "تبدیل فوریه"(Fourier transform) به محققان در انجام این کار کمک میکرد. مشکل این بود که این روش ناکارآمد بود و برای یک مجموعه داده با پایه N به محاسباتی با پایهی N به توان ۲ نیاز است.

در سال ۱۹۶۵ ریاضیدانان ایالات متحده، جیمز کولی(James Cooley) و جان توکی(John Tukey) راه حلی برای بهبود این فرآیند پیدا کردند. آنها با استفاده از روش "بازگشت" رویکرد برنامهنویسی "تقسیم و حل" را که در آن الگوریتم مدام خودش را تکرار می کند، فرآیند برنامه نویسی "تبدیل فوریه" سریع را آسانتر کرد که با افزایش N سرعت نیز افزایش پیدا میکرد و به طور مثال برای عدد ۱۰۰۰ سرعت ۱۰۰ برابر بیشتر میشود.

نیک ترفتن(Nick Trefethen)، ریاضیدان دانشگاه آکسفورد میگوید: این کشف در اصل کشفی بود که قبلا اتفاق افتاده بود توسط ریاضیدان آلمانی کارل فردریچ گاس(Carl Friedrich Gauss) در سال ۱۸۰۵ اما او هیچوقت آن را منتشر نکرد اما کولی و توکی این کار را انجام دادند و این یک اتفاق فوقالعاده در ریاضیات کاربردی و مهندسی است. از کد "تبدیل فوریه" بارها و بارها استفاده شده است.

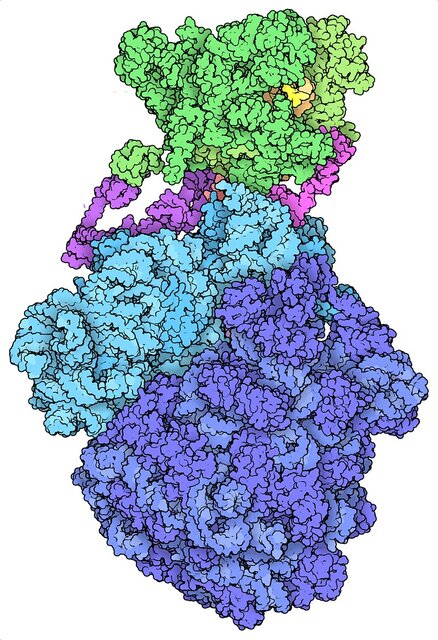

پاول آدامز(Paul Adams)، مدیر بخش بیوفیزیک مولکولی و تصویربرداری بیولوژیکی در آزمایشگاه ملی لارنس برکلی(Lawrence Berkeley National Laboratory) است. او میگوید هنگامی که در سال ۱۹۹۵ ساختار پروتئین باکتریایی GroEL را اصلاح و پالایش میکردیم این محاسبات به کمک فرآیند "تبدیل فوریه" ساعتها طول کشید و اگر کمک این فرآیند نبود نمیدانم چگونه این کار را میکردیم. احتمالا تا ابد به طول میانجامید.

دستهبندی مولکولی: بانک دادههای بیولوژیکی(۱۹۶۵)

بانکهای اطلاعاتی مولفههای یکپارچهی تحقیقات علمی امروزه هستند که به راحتی میتوان از این حقیقت که آنها به وسیلهی نرمافزارها تهیه میشوند چشمپوشی کرد. در طول چند دههی گذشته این منابع از نظر اندازه بسیار رشد کردهاند و بسیاری از حوزهها را شکل دادهاند اما این تغییرات در هیچکجا به اندازهی حوزهی زیستشناسی قابلتوجه نبوده است.

مجموعه دادههای عظیمی که امروزه از ژنومها و پروتئینها داریم ریشه در کارهای مارگارت دیهوف(Margaret Dayhoff) دارد. او پیشگام در بیوانفورماتیک در بنیاد تحقیقات ملی پزشکی در سیلور اسپرینگ(Silver Spring) مرینلند(Maryland) بود. در اوایل دههی ۱۹۶۰، هنگامی که زیستشناسان تلاش میکردند تا توالی آمینواسید را جداسازی کنند، دیهوف شروع به جمعآوری این اطلاعات برای جستجوی سرنخهایی از روابط تکاملی بین گونههای مختلف کرد.

اطلس او از توالی پروتئینها و ساختار آنها در سال ۱۹۶۵ با همکاری سه نویسندهی دیگر منتشر شد. آنها در این مقاله آنچه را که به عنوان توالی، ساختار و شباهتهای ۶۵ پروتئین شناخته میشد توضیح دادند. برونو استریسر(Bruno Strasser) که یک مورخ است در سال ۲۰۱۰ نوشت: این مجموعه اولین مجموعهای بود که برای پاسخ به یک سوال در یک تحقیق خاص مربوط نبود. کدهای آن بر روی کارتهایی پانچ شدند تا بتوان این مجموعه داده را گسترش داد و جستجو کرد.

"بانک داده پروتئین" که امروزه جزئیات بیش از ۱۷۰ هزار ساختار درشتمولکول را در اختیار دارد کار خود را در سال ۱۹۷۱ آغاز کرد. راسل دولیتل(Russell Doolittle) یک زیستشناس تکاملی از دانشگاه کالیفرنیا در سندیگو مجموعه داده پروتئین دیگری به نام "Newat" در سال ۱۹۸۱ ایجاد کرد و در سال ۱۹۸۲ بانک داده دیگری به نام "بانک ژن"(GenBank) ایجاد شد این مجموعه شامل دادههای دیانای( DNA ) است که توسط موسسه ملی بهداشت ایالات متحده نگهداری میشود.

ارزش چنین منابعی در ژوئیه سال ۱۹۸۳ مشخص شد هنگامی که گروههای مجزا به رهبری مایکل واترفیلد(Michael Waterfield) یک زیستشناس پروتئین و شیمیدان در موسسهی تحقیقات سرطان ایمپریال در لندن(Imperial Cancer Research Fund in London) و دولیتل به طور مستقل شباهتهایی در توالی یک عامل خاص در رشد انسان و پروتئینی در ویروس ایجاد کنندهی سرطان در میمونها گزارش دادند. این مشاهدات حاکی از مکانیزمی در ویروس بود که عامل رشد را شبیهسازی میکرد و باعث رشد کنترل نشدهی سلولها میشد.

جیمز استل(James Ostell)، مدیر سابق مرکز ملی اطلاعات زیستفناوری ایالات متحده میگوید: برای آن دسته از زیسشناسان که به کامپیوتر و آمار علاقهمند نیستند باید بگویم ما میتوانیم با بررسی توالیها اطلاعاتی دربارهی سرطانها به دست آوریم و علاوه بر طراحی آزمایشها برای بررسی فرضیهها، محققان میتوانند دادههای عمومی به دست آورند که تاکنون افرادی که واقعا دادهها را جمعآوری میکنند به آن دست نیافته باشند و هنگامی که دادههای محتلف به یکدیگر متصل شوند این قدرت افزایش مییابد. موضوعی که محققان مرکز ملی اطلاعات زیستفناوری (NCBI) در سال ۱۹۹۱ به وسیلهی جستجوگر پیشرفتهی آنتره(Entrez) به آن دست یافتند. این جستجوگر به محققان کمک می کند تا آزادانه از موضوعی همچون DNA به موضوع ادبیات یا پروتئین بروند و بازگردند.

پیشبینی آب و هوا: مدلسازی دورانی(۱۹۶۹)

با پایان جنگ جهانی دوم، جان ون نیومن(john von Neumann) پیشگام در عرصهی کامپیوتر، کامپیوترهایی کرد که پیش از آن برای محاسبهی مسیر پرواز و طراحی اسلحه استفاده میشدند برای حل مشکل پیش بینی آب و هوا تغییر کاربری داد.

مانابه توضیح میدهد: تا آن زمان پیشبینی آب و هوا تنها کاری تجربی بود که با استفاده از تجربه و ظن و گمان، وضعیت جوی آینده را پیشبینی میکردند. اما گروه ون نیومن قصد داشتند تا با استفاده از قوانین فیزیک به صورت عددی آبو هوا را پیشبینی کنند.

ونکاترامانی بالاجی(Venkatramani Balaji)، رئیس بخش مدلسازی سیستمها در آزمایشگاه دینامیک سیالات ژئوفیزیکی اداره ملی اقیانوسشناسی و اقلیمی پرینستون در نیوجرسی میگوید: این معادلات برای دههها شناخته شده بودند اما هواشناسان اولیه نتوانستند آنهارا حل کنند. برای انجام این کار باید شرایط جوی موجود در آن لحظه وارد میشد و تغییرات آن در طول مدتی کوتاه بررسی میشد و این کار تکرار میشد. این فرآیند بسیار طولانی و وقتگیر بود و تکمیل معادلهی ریاضیاتی آن پیش از تغییر آب و هوا ممکن نبود. در سال ۱۹۲۲ لوئیس فرای ریچاردسون( Lewis Fry Richardson)، یک ریاضیدان ماهها صرف انجام محاسباتی کرد تا آبو هوای مونیخ آلمان را پیشبینی کند اما نتایج آن کاملا غلط بودند از جمله آن پیشبینیهایی بود که تحت هیچ شرایطی رخ نخواهند داد. کامپیوترها این مشکل را قابل حل کردند.

در اواخر دههی ۱۹۴۰ ون نیومن گروه خود را برای پیشبینی وضعیت آب و هوا در موسسهی مطالعات پیشرفته پرینستون تاسیس کرد. در سال ۱۹۵۵ گروه دیگری کار بر روی "پیشبینی بینهایت آب و هوا" را آغاز کردند که نوعی مدلسازی جوی است.

مانابه که در سال ۱۹۵۸ به گروه مدلسازی جوی پیوست قصد داشت بر روی مدلهای جوی کار کند. همکار او کریک برایان(Kirk Bryan) نیز بر روی اقیانوسها کار میکرد. در سال ۱۹۶۹ آنها موفق شدند تا کارهایشان را ترکیب کنند و آنچه را که مجلهی نیچر در سال ۲۰۰۶ "نقطه عطفی" در محاسبات علمی خواند ایجاد کنند.

مدلهای امروزی میتوانند سطح سیاره را به مربعهای ۲۵ در ۲۵ کیلومتری تقسیم کنند و جو را به دهها سطح تقسیم میکند. مدل ترکیبی مانابه و برایان از مربعهای ۵۰۰ کیلومتری و ۹ سطح استفاده میکرد و تنها یک ششم کرهی زمین را پوشش میداد اما بالاجی میگوید: هنوز هم آن مدل کار فوقالعادهای انجام داد و گروه توانست برای اولین بار تاثیر افزایش سطح دیاکسید کربن را به وسیلهی فرآیند "درون رایانهای" بررسی کند.

حسابگر بلاسBLAS (۱۹۷۹)

محاسبات علمی معمولا شامل ریاضیات ساده و نمودار و ماتریس است فقط تعداد آنها زیاد است اما در دههی ۱۹۷۰ هیچ ابزار جهانی برای انجام این محاسبات وجود نداشت در نتیجه برنامهنویسانی که در حوزه علم کار میکردند زمانشان را صرف تولید کدهایی کارآمد برای انجام محاسبات ریاضیاتی میکردند به جای آن که بر روی سوالات علمی تمرکز کنند.

جهان برنامهنویسی نیاز به یک ابزار استاندارد داشت و در سال ۱۹۷۹ به آن دست یافت: زیربرنامهی جبر خطی پایه BLAS، استانداری است که تا سال ۱۹۹۰ به تکامل خود ادامه داد و دهها جریان اساسی برای نمودارها و ماتریسها مشخص کرد.

جک دونگارا(Jack Dongarra)، دانشمند رایانه در دانشگاه تنسی(Tennessee) که عضو گروه توسعهی بلاس بود میگوید: در واقع BLAS محاسبات ریاضی ماتریس و نمودار را به یک واحد محاسباتی کاهش میدهد.

تصاویر میکروسکوپی سازمان بهداشت جهانی(۱۹۸۷)

در اوایل دههی ۱۹۸۰، وین رازبند(Wayne Rasband) در حال کار با یک آزمایشگاه تصویربرداری از مغز در موسسهی ملی بهداشت ایالات متحده در بتسدا(Bethesda) مریلند بود. گروه یک اسکنر برای رقومی کردن(دیجیتالی کردن) (digitize) فیلمهای اشعه ایکس داشت اما راهی برای تحلیل آنها در کامپیوتر وجود نداشت. بنابراین رازبند برنامه کامپیوتری برای این موضوع نوشت. این برنامه برای کامپیوتر کوچک غیر شخصی ۱۵۰ هزار دلاری آمریکا به نام "PDP-۱۱" نوشته شده بود. سپس در سال ۱۹۸۷ شرکت اپل از کامپیوتر شخصی اش به نام "Macintosh II" رونمایی کرد که استفاده از آن راحتتر بود و مقرون به صرفه تر نیز بود.

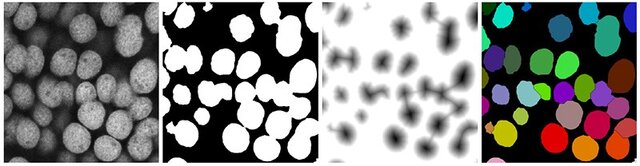

رازبند میگوید: این کامپیوتر جدید به نظر من به عنوان یک آزمایشگاه بررسی تصویر بسیار بهتر کار میکرد. او نرمافزارش را به یک پلتفرم جدید منتقل کرد و نام آن را نیز تغییر داد. سیستم تصویر برداری موسسه ملی بهداشت به محققان کمک کرد تا هر تصویری را درون هر رایانهای مشاهده کنند. این نرمافزار شامل ایمج جی(ImageJ) نرمافزاری مبتنی بر جاوا(JAVA) بود که رازبند آن را برای کاربران ویندوز و سیستمعامل لینوکس(Linux) نوشت.

بث سیمینی(Beth Cimini)، یک زیستشناس محاسباتی که بر روی پلتفرم تصویربرداری موسسهی کمبریج ماساچوشت کار میکند میگوید: ایمججی در حال حاضر اساسیترین ابزاری است که ما در اختیار داریم، من هیچ زیستشناسی نمیشناسم که از میکروسکوپ استفاده کرده باشد اما از ایمججی استفاده نکرده باشد.

رازبند میگوید: یکی از علتهای آن رایگان بودن این برنامه است. کوین الیسیری(Kevin Eliceiri) مهندس پزشکی دانشگاه ویسکانسین(Wisconsin) میگوید: همچنین آسان بودن این برنامه و امکان تنظیم ابزار آن بسته به نیاز این ابزار را برای کاربران مناسب کرده است.

جستجوگر توالی: بلاست(۱۹۹۰)

برای یک نرم افزار هیچ چیز بهتر از آن نیست که اسمش تبدیل به یک فعل در زبان شود. برای جستجو، گوگل و برای ژنتیک، "بلاست"(BLAST).

تغییرات تکاملی را میتوان در توالیهای مولکولی یافت. مانند جابهجایی، حذف، فاصله و بازسازی. با جستجوی شباهتهای بین این توالیها مخصوصا در میان پروتئینها، محققان میتوانند ارتباطات تکاملی را کشف کنند و بینشی در مورد عملکرد ژنها به دست آورند. برای این کار دادههای مولکولی که به سرعت رشد میکنند باید سریع و جامع بررسی شوند.

دیهوف در سال ۱۹۷۸ بخش مهمی از این مشکل را حل کرد. او ماتریس "جهش پذیرفته نقطهای" ابداع کرد که به محققان اجازه میداد تا ارتباط دو پروتئین را نه تنها براساس شباهت توالی بلکه براساس فاصله تکاملی آنها ارزیابی کنند.

در سال ۱۹۸۵ ویلیام پیرسون(William Pearson) از دانشگاه ویرجینیا شارلوتسویل(Virginia in Charlottesville) و دیوید لیپمن(David Lipman) از مرکز ملی اطلاعات زیستفناوری الگوریتمی به نام "FASTP" را معرفی کردند که ماتریس دیهوف را با توانایی جستجوی سریع ادغام میکرد.

سالها بعد لیپمن به همراه وارن گیش(Warren Gish) و استفن آلتچول(Stephen Altschul) از مرکز ملی اطلاعات زیستفناوری، وب میلر(Webb Miller) از دانشگاه ایلاتی پنسیلوانیا و جین میرز(Gene Myers) از دانشگاه آریزونا روش قدرتمندتری از پالایش را ابداع کردند: ابزار پایهای برای جستجوی برهمنهیهای موضعی یا "بلاست"

بلاست که در سال ۱۹۹۰ منتشر شد سرعت جستجو را به حدی رساند که از پس رشد دادهها بربیاید و همچنین شباهتهای دادههایی که از نظر تکاملی فاصله داشتند پیدا کند. این ابزار همزمان میتوانست احتمال رخ دادن چنین شباهتهایی را بررسی کند.

آلتچول میگوید: نتایج به دست آمده سریع بودند و مهمتر اینکه استفاده از آن آسان بود. در دورهای که اطلاعات به وسیلهی پست منتقل میشدند گیش یک سیستم پست الکترونیکی و بعد از آن هم ساختاری مبتنی بر وب ایجاد کرد تا محققان بتوانند کامپیوترهای مرکز ملی اطلاعات زیستفناوری را از راه دور جستجو کنند تا مطمئن شوند دادههایی که در دست دارند به روز است.

منبع مقالات پیشچاپ(arXiv.org) ۱۹۹۱

در اواخر دههی ۹۰ فیزیکدانان ذرات به طور معمول نسخههایی از کار خود را برای همکارانشان پست میکردند تا نظر آنها را بدانند.

در سال ۱۹۹۱، پائول گینسپراگ(Paul Ginsparg) یک فیزیکدان، که در آن زمان در آزمایشکاه ملی آلاموس مکزیک کار میکرد یک ایمیل خودکار ایجاد کرد که به صورت خودکار ارسال میشد تا زمینهای برابر برای همهی افراد در زمینه دسترسی به مقالات ایجاد کند. مشترکین روزانه لیستی از مقالات پیش از چاپ دریافت میکردند که هرکدام شناسه مخصوص خود را داشتند و با یک ایمیل ساده کاربران میتوانستند مقالهای را از سیستم کامپیوتری آزمایشگاه دریافت یا بازیابی کنند و همچنین لیستی از مقالات جدید بیابند و یا براساس نام مقاله یا نام نویسنده آن را جستجو کنند.

گینسپراگ قصد داشت تا مقالات را برای مدت سه ماه حفظ کند و سپس محتوی را محدود به جامعهی فیزیک ذرات کند اما یکی از همکارانش او را متقاعد کرد که مقالات را به طور بینهایت حفظ کند.

در سال ۱۹۹۳، گینسپارگ این سیستم را به شبکه جهانی وب منتقل کرد و در سال ۱۹۹۸ نامی به آن داد که تا امروز باقی مانده است: arXiv.org

این منبع اطلاعاتی که اکنون سیامین سال خود را میگذراند شامل ۱.۸ میلیون پیشچاپ مقالات به طور رایگان است و ماهانه ۱۵ هزار مقاله ارسالی و ۳۰ میلیون دانلود دارد.

جستجوگر دادهها: نوتبوک آیپایتون(۲۰۱۱)

فرناندو پرز(Fernando Pérez) که دانشجوی کارشناسی ارشد در سال ۲۰۰۱ بود، تصمیم گرفت مولفههای اصلی زبان برنامهنویسی پایتون(Python) را در دست بگیرد.

پایتون یک زبان برنامهنویسی تفسیری است که یعنی برنامهها خط به خط اجرا میشوند. برنامه نویسان میتوانند از ابزاری به نام "REPL" استفاده کنند و کدی بنویسند که برنامهای به نام مفسر آن را اجرا کند. "REPL" به جستجوی سریع و تکرار را فراهم میکند اما پرز خاطرنشان کرد که پایتون برای علم ساخته نشده بود بنابراین او نسخهی خودش را ساخت که نتیجهی آن آیپایتون(IPython) شد. یک مفسر تعاملی که پرز در دسامبر ۲۰۰۱ از آن رونمایی کرد. یک دهه بعد پرز با همکاری برایان گرنجر(Brian Granger) یک فیزیکدان و ایوان پترسون(Evan Patterson) یک ریاضیدان این ابزار را به مرورگر انتقال دادند. با راهاندازی آیپایتون نوتبوک انقلابی در عرصهی دادههای علمی ایجاد شد. این نرمافزار مانند سایر نوت بوکها کدها، نتایج و متن را در یک فایل ادغام میکرد اما برخلاف آنها یک نرمافزار باز بود و از توسعهدهندگان دعوت میکرد تا در توسعه آن سهمی داشته باشند.

الکس نت(AlexNet) ۲۰۱۲

هوش مصنوعی دو نوع دارد. یکی از قوانین کدگذاری شده استفاده می کند و دیگری یک کامپیوتر را قادر میسازد تا با الگوبرداری از ساختار عصبی مغز "یادگیری" انجام دهد.

جفری هینتون(Geoffrey Hinton) دانشمند رایانه از دانشگاه تورنتو کانادا میگوید: برای دههها محققان حوزهی هوش مصنوعی این رویکرد را "بیمعنی" میخواندند و آن را رد میکردند. در سال ۲۰۱۲ دانشجویان هینتون، الکس کریژفسکی(Alex Krizhevsky) و ایلیا ساتسکور( Alex Krizhevsky) خلاف این موضوع را ثابت کردند.

هینتون میگوید: در همایشی سالانه که در ImageNet برگزار میشود رقابتی بین محققان ایجاد میشود تا یک هوش مصنوعی را به وسیلهی دادههای یک میلیون تصویر از اجسام روزمره تربیت کنند و سپس الگوریتم به دست آمده را بر روی یک مجموعه عکس جداگانه آزمایش کنند. در زمانی که بهترین الگوریتمها یک چهارم دستهبندیها را اشتباه انجام میدادند الگوریتم "یادگیری عمیق" کریژفسکی و ساتسکور که مبتنی بر شبکهی عصبی بود این خطا را تا ۱۶ درصد کاهش داد. هینتون میگوید: ما اساسا میزان خطا را نصف کردیم.

هینتون میگوید: موفیت گروه در سال ۲۰۱۲ نشان دهندهی ترکیبی از مجموعه دادههای آموزش، برنامهنویسی عالی و قدرت نوظهور واحد پردازش گرافیکی است. ناگهان ما موفق شدیم الگوریتم را ۳۰ برابر سریعتر اجرا کنیم.

وی افزود: موفقیت واقعی در اصل سه سال قبلتر رخ داد، هنگامی که آزمایشگاهش شبکهی عصبی ساخت که میتوانست گفتار را با دقتی بیشتر از سایر هوشهای مصنوعی تشخیص دهد. این موفقیتها باعث شده که امروزه تلفنهای همراه دستورهای گفتاری را بفهمند و ابزارهای تجزیه و تحلیل عکس بتوانند سلولها را تشخیص دهند و به همین علت است که AlexNet در میان بسیاری از ابزاری که علم و جهان را متحول کردهاند جای میگیرد.

پاسخ ها